2020年5月11日

2020/6/9〜6/12 JSAI 2020(オンライン開催)で2件の研究を発表します

今年で34回目になる人工知能学会全国大会(The Japanese Society for Artificial Intelligence, JSAI)にて、去年に続きLeapMindから2件の研究発表をいたします。 今回のブログでは、論文の概要をお伝えいたします。 (去年は「ConvRNNの計算量を削減」、「ファイナルバッチ正規化」について発表いたしました。詳細はこちら なお、今回の人工知能学会全国大会は、新型コロナウイルスの感染防止のため、オンラインでの開催となります。

目次

- 発表(1) Designing Lightweight Feature Descriptor Networks with Depthwise Separable Convolution

- 発表(2) Gated extra memory recurrent unit for learning video representations

- JSAI2020オンライン参加・聴講について

- インターン・正社員募集中

発表(1) Designing Lightweight Feature Descriptor Networks with Depthwise Separable Convolution

公式情報:タイムテーブル 講演日時:2020年6月10日(水) 10:00〜10:20 配信方法:Zoom(オンライン配信) プログラム番号:2K1-ES-2-04

Y. R. Wang and A. Kanemura、“Designing Lightweight Feature Descriptor Networks with Depthwise Separable Convolution”、人工知能学会全国大会(JSAI)、日本、2020。

画像から特徴点とその記述子(局所特徴量)を抽出することは、コンピュータービジョンの基本的な手法の1つであり、近年いくつかの深層学習法が提案されています。ただし、既存の深層ネットワークは、精度向上が目的であり、組み込みデバイスで実行可能な実用性の高いネットワークの研究開発はそれほど活発ではありません。

この論文では、局所特徴量を抽出する深層ネットワークを軽量化することを目的としました。本論文は、主に畳み込み演算を効率化することで、SoTA手法であるRF-Netの検出器モデルの理論上の計算負荷を80%削減できる一方で、画像マッチングタスクの性能劣化は11%に留まることを報告しています。このようにネットワークを軽量化することで、より多くの実社会応用に繋がると期待しています。

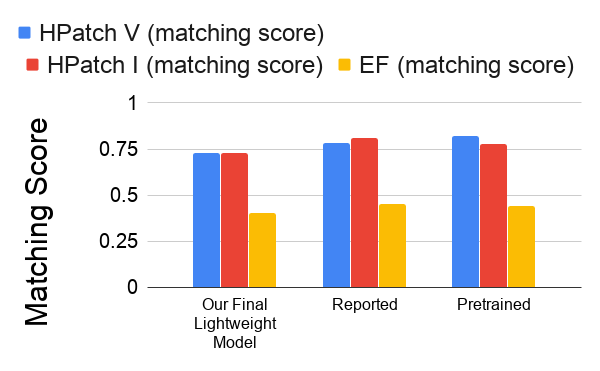

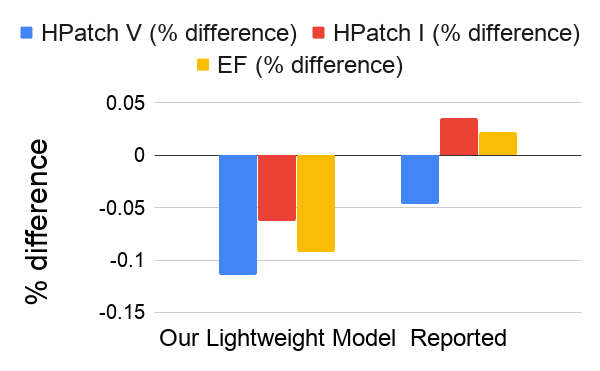

以下の図は、論文からの抜粋で、マッチング性能の変化を定量的および定性的に分析しています。 データセットには、RF-Net論文と同様に、HPatchesとEF [arXiv]を採用しています。

詳しくは5月22日以降にJSAIのWebサイトで公開される我々の論文をご覧ください。(JSAI2020予稿集)

最終的な軽量RF-Net検出子との比較。"Reported"はRF-Net論文で報告された数値、"Pretrained"はhttps://github.com/Xylon-Sean/rfnetから得られた訓練前のRF-Netモデルのパフォーマンスを示す。

RF-Netの"Pretrained"モデルに対する、我々の最終的な軽量RF-Net検出器モデルとRF-Netの"Reported"モデルとのマッチングスコアのパーセンテージ差異

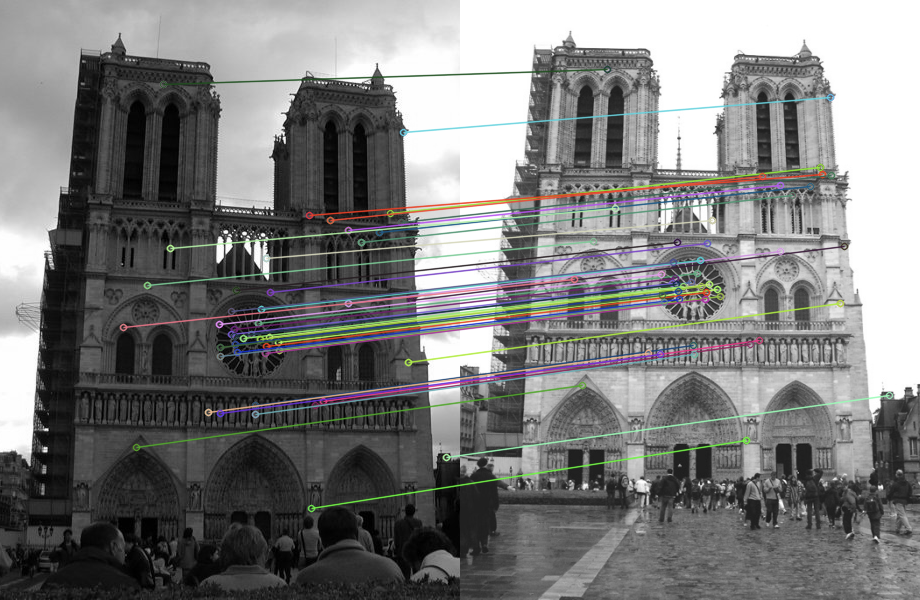

Original RF-Net author matched image

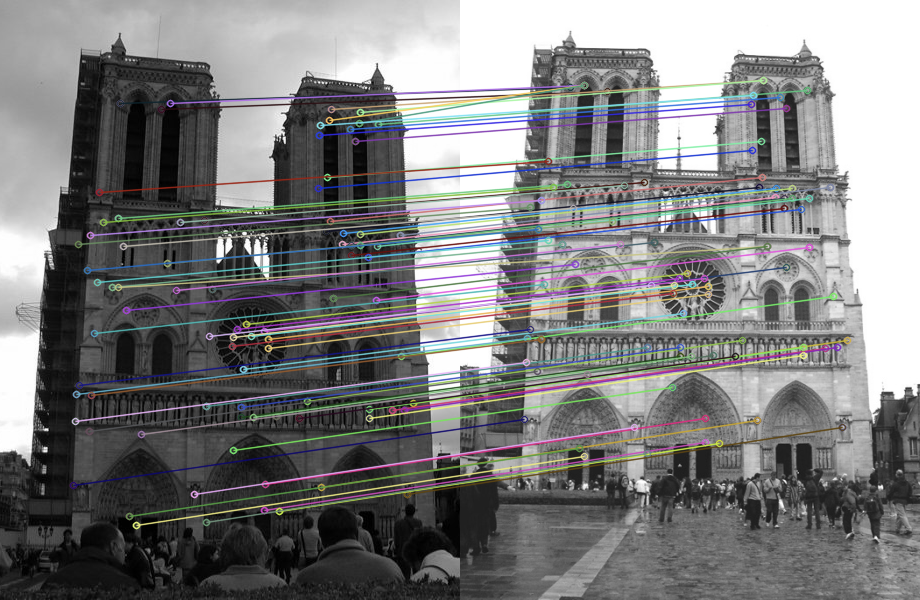

Our final lightweight detector model matched image

発表(2) Gated extra memory recurrent unit for learning video representations

公式情報:タイムテーブル 講演日時:2020年6月10日(水) 16:30〜16:50 配信方法:Zoom(オンライン配信) プログラム番号:2K5-ES-2-03

D. Vazhenina and A. Kanemura、“Gated extra memory recurrent unit for learning video representations”、人工知能学会全国大会(JSAI)、日本、2020。 映像からその表現を学習するには、映像内の時間的構造を捉えられるモデルを利用することが重要です。有用な表現を学習できれば、オブジェクト追跡やアクション認識など、さまざまな視覚認識タスクを実行することができます[1, 2]。ビデオフレーム(画像列)の処理を行う代表的なニューラルネットに、畳み込み再帰ニューラルネット(ConvRNN, convolutional recurrent neural nets)があります。ConvRNNは、空間情報と時間情報の両方を処理することが可能です。時間情報を保持するために、RNNではゲーティングメカニズムを利用しており、ベースラインとしてよく使われるConvLSTMには、3つのゲートがあります[2]。 ただし、ConvLSTMには、時間情報を短時間しか保持できたいという欠点があります。このため、例えばオブジェクトが一時的に遮蔽されるだけで大きな誤差が発生してしまいます[3]。この欠点を補うため、ゲートの数を増やし、メモリユニットをより複雑にするという対策がありますが、時間情報の保持時間が向上する一方で、モデルが複雑になり計算負荷が増えてしまうという新たな問題が生じてしまいます。

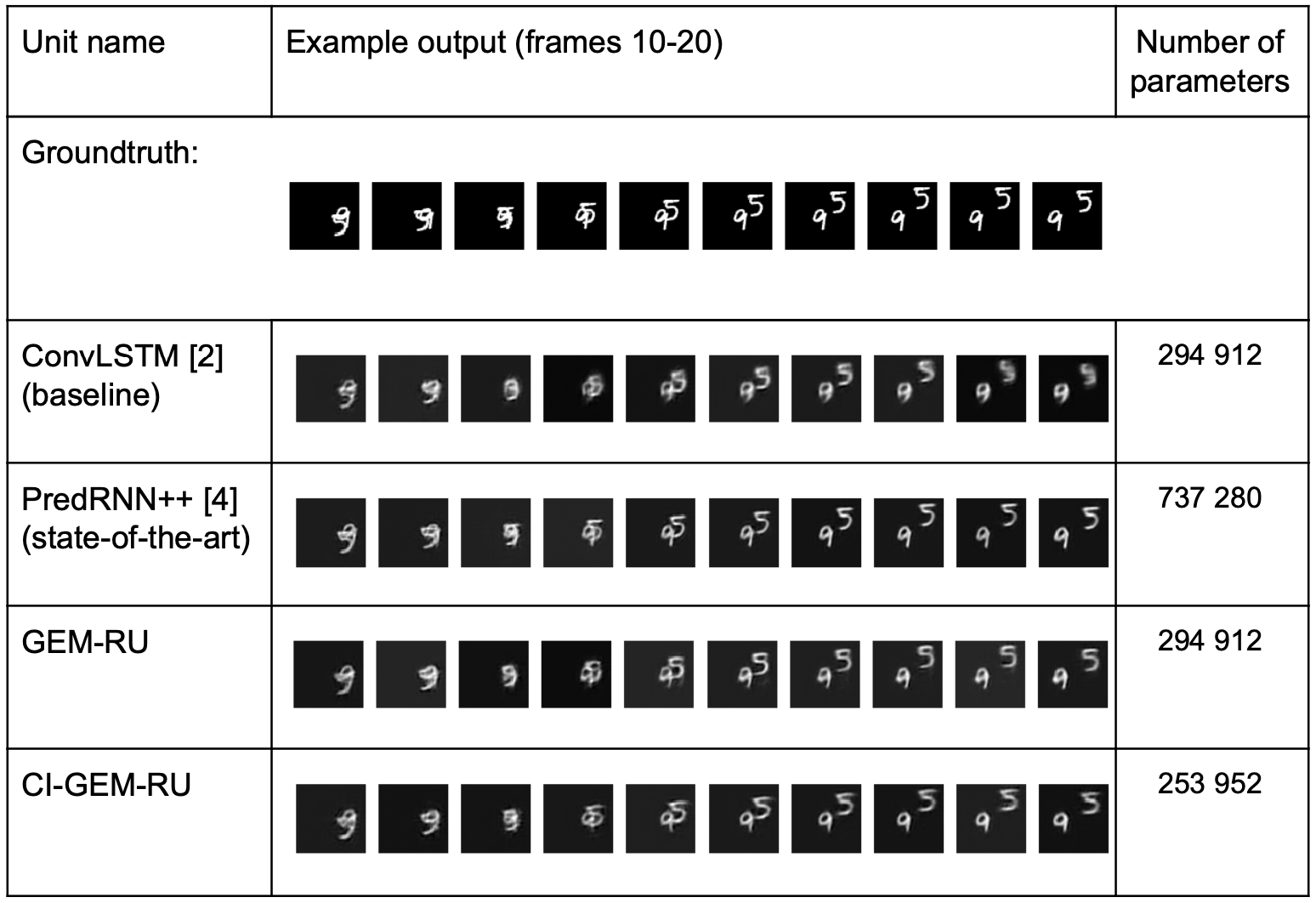

我々のJSAI 2020の論文では、計算負荷を抑えつつ、時間情報を長く保持する手法を検討しました。具体的には、時間情報を保持・制御するために、2つのメモリユニットと2つのゲートを備えた、gated extra memory recurrent unit(GEM-RU)を考案しました。図1からわかるように、GEM-RUは、パラメタ数をベースラインと同等に抑えつつ、遮蔽が起きた後の予測精度を向上させています。さらに、我々の以前の研究[5]で提案したアイディアである、畳み込み演算のアダマール積での置き換えを採用したCIC-GEM-RUを考案することで、パラメーター数と乗算の数を削減し、計算負荷をさらに減少させることにも成功しました。CIC-GEM-RUは、ベースラインと比較して、MSEで5%優れており、パラメーターの数は14%、乗算の数は25%減少しています。計算負荷が減ったことで、より応用範囲が広がると期待しています。

こちらの研究についても、詳しくは5月22日以降にJSAIのWebサイトで公開される我々の論文をご覧ください。(JSAI2020予稿集)

図1:提案したGEM-RUと削減したCI-GEM-RUと、最先端のユニットおよびベースラインユニットとの比較。

[1] Denton, Emily L. "Unsupervised learning of disentangled representations from video." Advances in Neural Information Processing Systems (NIPS), 2017. [2] Xingjian, Shi, et al. "Convolutional LSTM network: A machine learning approach for precipitation nowcasting." Advances in neural information processing systems (NIPS), 2015. [3] Wang, Yunbo et al. "PredRNN: Recurrent neural networks for predictive learning using spatiotemporal LSTMs." Advances in Neural Information Processing Systems (NIPS), 2017. [4] Wang, Yunbo et al. "PredRNN++: Towards a resolution of the deep-in-time dilemma in spatiotemporal predictive learning." International Conference on Machine Learning (ICML), 2018. [5] Vazhenina, Daria and Kanemura, Atsunori. “Reducing the number of multiplications in convolutional recurrent neural networks (ConvRNNs)”, Advances in Intelligent Systems and Computing (AISC), volume 1128, Springer, 2019.

JSAI2020オンライン参加・聴講について

2020年度 人工知能学会全国大会はオンライン開催になりましたが、参加また講演を聴講するには事前参加登録する必要があります。人工知能に関連する国内の研究者が一堂に集い、人工知能に関連する最新の技術動向・研究成果やアイデアなどの発表がされるので、ぜひこの機会にオンライン参加をご検討ください。

参加申し込みはJSAI2020公式サイトよりお手続きください。

インターン・正社員募集中

世界中の優秀なエンジニアと肩を並べ、LeapMindで実務経験をしませんか?

LeapMindでは技術インターンをしたい、Deep Learningに興味のある学生や正社員を通年で募集しています。 ソフトウェア開発、プロセッサ設計などのプロジェクトに参加し、先端技術を社会に届ける一端を担ってみませんか。